Un algoritmo es un conjunto ordenado y sistemático de reglas y operaciones lógicas que nos permite realizar un cálculo para encontrar la solución a un tipo de problema en concreto.

Ahora, si llevamos este termino a relacionarlo con las búsquedas en la red, podríamos definirlo:

¿Qué es un algoritmo de búsqueda en Internet?

Un algoritmo de búsqueda en Internet es un conjunto de instrucciones que describen el procedimiento a seguir para lograr encontrar un resultado determinado y concreto en la red, dentro de una estructura de datos de mayor envergadura.

Quizás explicado así suene complicado, pero si nos acercamos al término desde el punto de vista informático, encontramos una explicación más clara, ya que un algoritmo es un concepto fundamental de ese campo.

Esta palabra supone una prescripción precisa de las acciones que se deben realizar para alcanzar un fin específico.

Así, podemos suponer que cualquier instrucción es un algoritmo si:

- Sus puntos no permiten diferentes variantes del desarrollo.

- Las indicaciones están proporcionadas para todos los escenarios posibles.

Pero, ¿sobre qué hablamos cuando nos preguntamos qué es un algoritmo de búsqueda en Internet?

Cuando vamos a buscar algo (por ejemplo, en Google), lo que queremos es una respuesta exacta y filtrada, no millones de páginas que no tienen nada que ver con nuestra petición.

Un algoritmo es entonces la perfecta herramienta para acotar esa búsqueda a la mínima expresión, ya que es un programa informático que busca pistas para darte exactamente lo que has pedido.

Al mismo tiempo, éstos son también fórmulas que identifican tus preguntas y las convierten en una lista de potenciales respuestas. Para lograrlo, los algoritmos de búsqueda de Google se basan en cientos señales únicas o factores.

Esos factores hacen que sea posible casi adivinar lo que realmente estás buscando en Internet para ofrecerte una lista de posibles respuestas, ordenadas de mayor a menos según su relevancia para esa búsqueda en concreto.

Entonces, ¿puedo saber cómo funciona un algoritmo de búsqueda como el de Google?

Aunque, por motivos obvios, no podemos descifrarlo por completo, si que podemos saber algunos aspectos básicos y, gracias a ellos, deducir los requisitos mínimos que ese algoritmo viene teniendo en cuenta.

Y, por supuesto, podemos obtener información acerca de cómo funciona para optimizar nuestra estrategia SEO. Sin embargo, no siempre es fácil de obtener dicha información.

Es por ello que, en este post también contamos con Rost Torchinskyi, que será quien te va a contar las particularidades de los algoritmos de búsqueda en Internet y las históricas de tres de los principales buscadores en la actualidad.

¿Cómo funcionan los 3 algoritmos de búsqueda más populares de Internet?

Quiero compartir hoy contigo un tema que cada vez le interesa a más gente en internet: cómo funciona un algoritmo de búsqueda y cuál de ellos está pisando más fuerte en la actualidad.

Como bien sabemos, hablar de Internet es casi hablar de nuestro amigo Google, quien periódicamente actualiza su algoritmo de búsqueda, perfeccionándolo cada vez aún más y haciéndolo más inteligente.

Un par de sus objetivos desde hace un tiempo a esta parte, por ejemplo, son priorizar la WPO de un sitio Web y la navegación desde dispositivos móviles, cada vez más usados en nuestra sociedad.

Pero no sólo Google se ha interesado en este aspecto, sino todos los buscadores importantes, en su intención de mejora continua.

En definitiva, tenemos ante nosotros una plataforma que, con su algoritmo de busqueda, premia cada vez más el contenido de calidad y, sobre todo, ofrecer al usuario aquellos contenidos que se adaptan mejor a su intención de búsqueda o “query”.

Bing, Yahoo! o Yandex se encuentran también en un proceso de mejora de sus algoritmos de búsqueda para que los usuarios consigan los mejores resultados “invirtiendo” el menor tiempo posible en realizar una búsqueda en Internet.

Por supuesto, estos cambios afectan a las estrategias de Posicionamiento SEO de los marketeros y de los propietarios de dominios web.

Hablar de los más importantes supone, por supuesto, incluir a los buscadores más populares:

- Bing

- Yandex

Por supuesto, es de estos tres de los que nos ocuparemos en este post.

¿Comenzamos?

¿Cuáles son los buscadores más conocidos y cómo son sus algoritmos de búsqueda?

A continuación, veremos cuáles son los motores de búsqueda más populares del mundo y repasaremos la evolución de sus fórmulas y actualizaciones.

► Yandex

Este programa fue creado en 1988 por la empresa CompTek, aunque el motor de búsqueda Yandex-Web fue presentado al mundo el día 23 de septiembre de 1997.

La primera versión del programa de búsqueda llamado “Yandex” apareció en 1993, aunque en aquella época era más bien una herramienta para encontrar información dentro de un solo sitio web.

“Yandex” no es el primer motor de búsqueda nacido Rusia (antes que él ya existían Rambler y Aport), pero a poco de ver la luz comienza rápidamente a ganar audiencia. Tanto, que en 2001 se convierte en el buscador más conocido del segmento ruso, pasando a ser líder de ese mercado.

Hoy en día “Yandex” es la compañía de Internet más grande de Europa, con una capitalización de 10 mil millones de dólares (según datos del 2013).

Por su parte, el motor de búsqueda “Yandeks.Poisk” a principios de 2013 era el cuarto en el mundo, con 4,84 mil millones de peticiones de búsqueda, y el segundo entre los motores de habla no inglesa después de “Baidu”.

Actualizaciones y algoritmo de búsqueda de Yandex

En 2008 Yandex lanzó una actualización llamada Magadán (dicho sea de paso, Yandex nombra sus updates tomando el nombre de distintas ciudades rusas).

Con esta actualización se resolvía el problema de interpretación de abreviaturas y transliteración y, además, la correlación entre palabras con la misma raíz.

Esa update es nuevamente actualizada unos meses después añadiendo factores de ranking adicionales (como por ejemplo, dar prioridad al contenido exclusivo).

En 2008 y 2009 ven la luz Najodka y Arzamás, cuyo objetivo es mejorar los resultados para “queries” con conjunciones y preposiciones.

Con ello, las SERPs ofrecen resultados más informativos en comparación con la proporción previa de resultados anteriores; también desde aquí se enfocan en aspectos relacionados con la geolocalización a la hora de realizar las búsquedas.

A finales del año 2009, Yandex anuncia la actualización Snezhinsk: una tecnología más compleja que analiza el contenido de la página teniendo en cuenta un mayor número de factores.

De ahí que el contenido relevante y de calidad se convirtiera en un factor esencial

Llega septiembre de 2010 y aparece Obninsk, poniendo su atención en los SEO-enlaces (backlinks pagados) y en disminuir el impacto de los mismos en el posicionamiento de páginas.

En agosto 2010 la búsqueda empieza a personalizarse, pero es en diciembre de 2012 cuando nace Kaliningrado, la cual provee una personalización de búsqueda global según los intereses del usuario.

Gracias a Kaliningrado, la información sobre las acciones de ese usuario se actualizará una vez al día, y se segmentará teniendo en cuenta la duración de la búsqueda y la personalización de la misma.

Entonces, el impacto del SEO no solo provenía de backlinks y búsqueda de palabras clave importantes, sino de todo en conjunto: el diseño, la usabilidad, el contenido, etc.

Después de la modificación de Kaliningrado llamada Dublín (que fue lanzada en el año 2013), el buscador comienza a memorizar las acciones más recientes del usuario.

Recientemente, en abril de 2015, los backlinks pagados dejan de ser un factor influyente al rankear las páginas web.

Cuando los dominios con enlaces pagados comienzan a perder posiciones, Yandex pretende librarse del ‘spam’ de backlinks y que los dueños de dominios concentren sus esfuerzos SEO en mejorar contenido, usabilidad, diseño y servicio.

Esto significa (para cerrar el tema de las actualizaciones de Yandex) que desde ese momento, deja de ser significativo conseguir esos backlinks que eran tan importantes dentro de las estrategias SEO en RUnet.

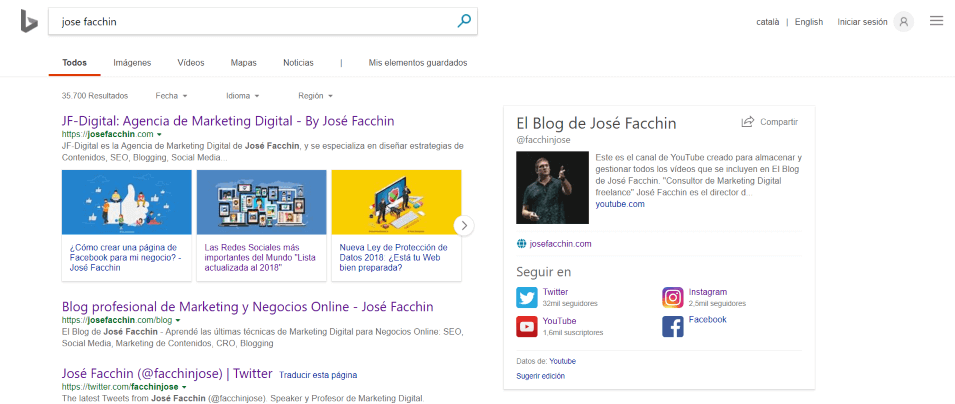

► Bing

Bing es el buscador web de Microsoft por excelencia, presentado en mayo de 2009.

En julio del 2009, Microsoft y Yahoo! anuncian que Bing reemplazaría a Yahoo! Search, momento en el que también lanzan la nueva araña web, llamada MSN bot 2 (previamente denominada MSN Search).

Todo esto demuestra que éste es un motor de búsqueda relativamente nuevo. A pesar de ello, Bing ocupa el segundo lugar en el ranking de buscadores más populares según volumen de tráfico.

A pesar de esta popularidad, los cambios de su algoritmo de búsqueda no son tan famosos como los de Google o de Yandex y, a diferencia de esos dos, Bing no revela las updates realizadas y no les da nombres como lo hacen Yandex y Google.

Es por ello que no nos queda nada más que describir las diferencias en cuanto a resultados de búsqueda y posicionamiento.

Desde hace años Bing presta especial atención a:

- Las imágenes.

- El flash.

- Los vídeos.

- Los audios.

Aunque actualmente Flash es una tecnología un poco antigua (reemplazada por HTML5), hace no muchos años era una ventaja de la que este buscador podía presumir.

Hoy en día, este buscador pone más atención a palabras clave directas. Por ello, si quieres adaptar tu sitio web para un mejor posicionamiento en Bing, estás obligado a construir tu estrategia SEO sobre palabras clave determinadas y concretas.

En octubre de 2011, Microsoft anunció que estaba trabajando en una actualización que recibió el nombre de “Tiger” (en este caso, sí le puso nombre), cuyo objetivo era proporcionar resultados más relevantes y más rápidos para el usuario, tras mejorar el procesamiento de queries.

Los backlinks, al contrario que la actividad en redes sociales, no gozan del favor de Bing. De hecho, éste siempre ha demostrado mucha más predilección por el engagement en plataformas sociales.

Ha llegado el momento de hablar del motor de búsqueda más grande y conocido del mundo.

Este sistema (con una cuota de mercado del 77.05%) maneja 41.345 millones de consultas e indexa más de 25 millones de páginas web… ¡Al mes!

En una conferencia cerrada a principios de Mayo de 2014, el representante de Google mencionó que hoy en día están indexados 60 billones de documentos. Imagínate la cantidad actual, ya a finales de 2018…

Como se puede comprobar con los resultados de las pruebas, el contador de la búsqueda de Google se limita al número 25 270 000 000, número que también está afectado por los filtros incorporados en la dispensación del algoritmo de clasificación.

El motor de búsqueda de Google fue creado como un proyecto escolar por los estudiantes de la Universidad de Stanford Larry Page y Sergey Brin.

En 1996 trabajan para el sistema de motores de búsqueda llamado BackRub y, basándose en él, crean dos años más tarde un nuevo motor de búsqueda: Google.

Desde los inicios comienzan a aplicar un método de control OKR transparente que más tarde define la línea corporativa de la empresa en cuanto a planificación y desarrollo.

¿Cuáles son los diferentes algoritmos de búsqueda que ha tenido Google a lo largo de su historia?

A continuación, te mostraré las diferentes variaciones del algoritmo de Google, todo ello de manera cronológica y atendiendo al significado y función de cada actualización:

1. Google Panda (actualización de “Caffeine”)

El 10 de agosto del 2009 se anuncia una actualización llamada Caffeine, que promete un rastreo más rápido, la expansión e integración de la indexación y la clasificación en tiempo casi real.

El lanzamiento tiene lugar, finalmente, en junio del año 2010.

En febrero del 2011 Google lanza Panda, una actualización de amplio espectro que afecta al 12% de queries de búsqueda.

Esta actualización busca tomar medidas activas contra el spam, las granjas de contenido, el web scraping y los sitios web con alto porcentaje de anuncios en comparación con el porcentaje de contenido.

Durante el año 2011, Google actualiza Panda y pasa a la versión Panda 2.1.

EL gigante de Internet realiza permanentes cambios, con el objetivo de mejorar de forma considerable tanto la indexación como la experiencia del usuario y su considerable mejora.

Después de lanzar Panda 2.4, el algoritmo de búsqueda también empieza a funcionar en todos los idiomas, excepto chino, japonés y coreano.

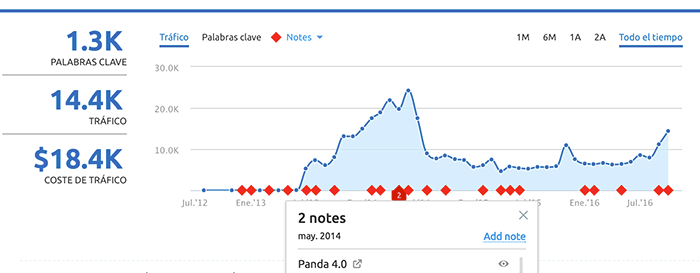

En mayo del 2014 ve la luz Panda 4.0, para terminar el año con la actualización a la versión 4.1.

Y en 2015, Google integra Panda a su core general de búsqueda.

» Ejemplo de penalización de Google Panda

2. Algoritmo “Freshness”

En noviembre de 2011 se lanza Freshness, una actualización que da prioridad a los resultados de búsqueda más recientes.

Pero no es hasta febrero de 2012, después del lanzamiento de Venice, que se empiezan a priorizar los resultados de búsqueda en relación a la geolocalización.

3. Google Penguin (el adiós al ‘Black Hat’)

En abril del mismo año ve la luz Google Penguin update.

Esta actualización nace con la idea de penalizar a los sitios web que usan técnicas de ‘black hat SEO’ para mejorar el posicionamiento de un dominio de forma artificial.

Google Penguin se plantea como prioridad acabar con el spamdexing, esto es, uno de los métodos para manipular la relevancia de las páginas indexadas por un buscador.

Al mismo tiempo, se plantea como objetivo primordial mostrar los sitios web de mayor calidad en las primeras posiciones de los resultados de búsqueda de Google.

En septiembre de 2016, Penguin se integra al algoritmo de búsqueda principal. Ahora este funciona en tiempo real y es mucho mas granular.

Ya no afecta a la clasificación de todo un sitio web completo, sino que a cada URL de manera individual.

» Ejemplo de penalización de Google Penguin

4. Google Hummingbird

Entre agosto y septiembre de 2013 aparece Google Hummingbird, considerada como la primera gran actualización después de Caffeine, y destinada principalmente a mejorar el proceso de indexación.

En contraposición con otros algoritmos de búsqueda más enfocados en cada palabra de query por separado, Google Hummingbird (además de tener en cuenta cada palabra) prioriza la consulta general tomando como base la frase u oración.

El objetivo de Google Hummingbird se centra en que el buscador entienda las relaciones entre varias palabras clave y múltiples conceptos.

Con todo esto, Google pretende que la búsqueda sea más humana, y para ello apuesta por las búsquedas semánticas a fin de obtener resultados más relevantes para el usuario.

Hay que decir que la actualización Hummingbird no supone un gran impacto en el SEO, sino que se centra en conseguir que los mejores resultados vengan respaldados por un contenido natural y relevante.

Así, Google Hummingbird asegura un mejor posicionamiento de las palabras clave de larga cola (long tail), que se hacen más naturales para dar respuesta a las preguntas reales de los usuarios.

¿En qué afecta este algoritmo de búsqueda a los creadores de contenido?

Esto, lógicamente, lo vuelve más maleable al alinearlo con el uso natural de la lengua, adaptada a conversaciones reales y no a palabras clave puras y duras que los especialistas de SEO atribuyen a sus páginas web.

En el año 2014 se lanza otra gran update, Google Pigeon, con el objetivo de dar prioridad a los resultados cercanos de búsqueda, algo muy beneficioso para negocios y emprendedores locales (y, por supuesto, para el usuario).

Además, por razones de seguridad, en ese mismo año Google anuncia su preferencia por los sitios web que utilizan el protocolo HTTPS.

En el año 2015, el buscador de buscadores divulga un nueva update que da prioridad a los sitios web que se muestran mejor en dispositivos móviles, responsive, no afectando a los resultados de búsqueda desde el ordenador (por el momento…). A su vez, Google insiste en que las webs sean ‘mobile friendly’.

Con ese fin, a principios de marzo de ese año advierte a los webmasters sobre su intención de lanzar una actualización que permita a los usuarios recibir resultados aún más relevantes y amigables a sus dispositivos móviles.

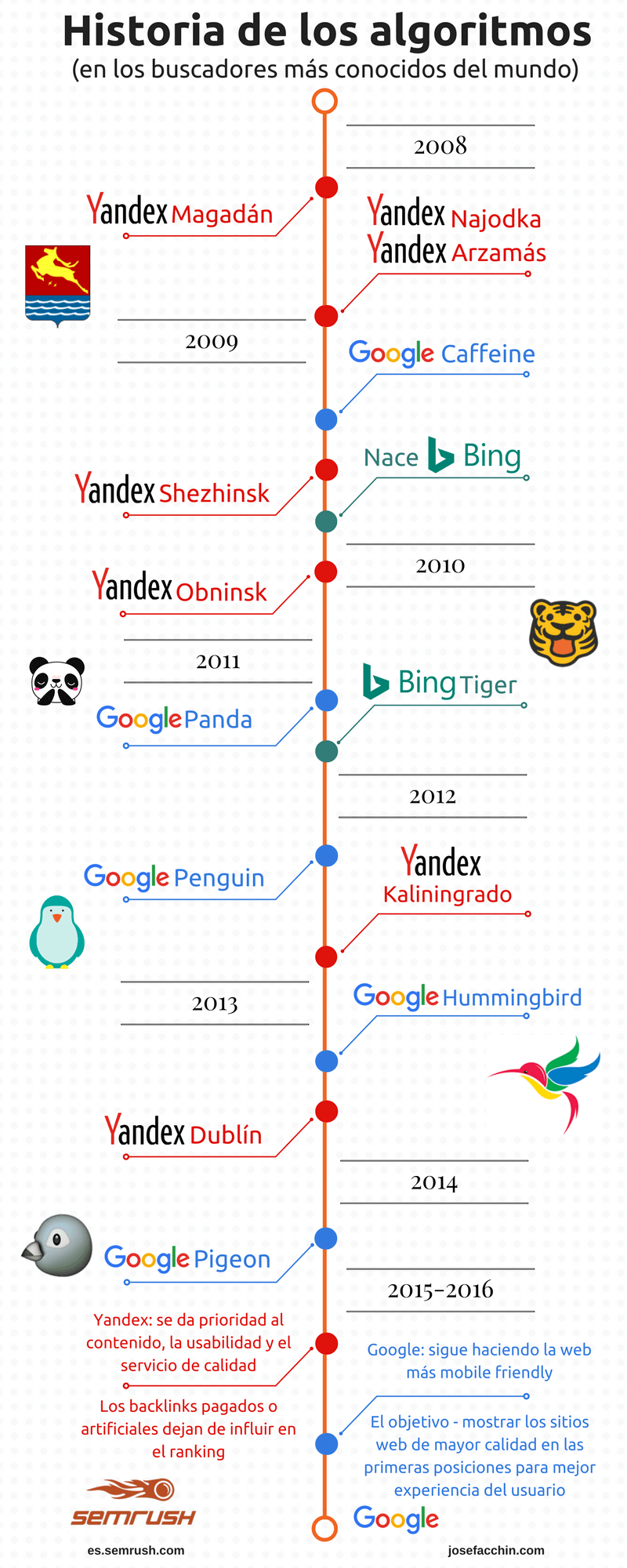

A continuación comparto contigo una infografía que resume toda la guía, la cual podría continuar hasta los años venideros, en los que seguramente se actualicen los algoritmos de búsqueda de Google y los principales motores existentes en la red.

La historia de los diferentes algoritmos de búsqueda a lo largo del tiempo

Concluyendo

Hasta aquí hemos llegado con este post sobre qué es un algoritmo de búsqueda, su desarrollo y evolución a lo largo del tiempo.